이미지 데이터 인공지능 학습

제조 현장의 눈 ‘컴퓨터 비전’, 제품 결함 파악·미세조직 분석 등 적용 활발

■연재 순서

1. 제조 중소·중견기업 인공지능 기술개발

2. 제조공정 데이터 취득(DAQ) 시스템 개발

3. IoT 센서 패키지 HW/SW 개발 및 데이터 송·수신

4. 데이터 전처리

5. 제조업 인공지능 적용

6. 인공지능 데이터 및 알고리즘 유형

7. 디지털 트윈 구축 및 HW/SW 개발 적용

8. 시계열 데이터 인공지능 학습 (예)

9. 이미지 데이터 인공지능 학습 (예)

10. 뿌리 제조기업의 공정지능화 과제

■컴퓨터 비전

컴퓨터 비전은 인공지능 기술을 시각적 인지 부분에 적용하는 연구 분야로 생각할 수 있다. 시각은 인간의 오감(시각, 청각, 후각, 미각, 촉각)중에 가장 많은 정보량을 갖는 감각으로 다른 네 종류의 감각에 비해 수백 배 이상의 정보량을 뇌에서 처리하는 것으로 알려져 있다. 눈을 통해 받아들인 이미지를 뇌에서 해석하며 시각적 인지를 하게 되는데, 이러한 시각적 인지는 기본적으로 입력이미지로부터 패턴을 인식하는 행위라고 말할 수 있다.

인공지능 기술을 도입한 컴퓨터 비전 시스템은 인간의 이러한 시각적 인지 시스템에 착안하여, 눈의 역할을 하는 카메라, X-ray, CT 스캔 등의 다양한 감지 장치와 인공신경망을 활용한 인공지능 알고리즘이 해석 장치의 역할을 담당한다.

그 중 딥러닝 네트워크는 여러 층을 가진 신경망을 일컫는 용어이며, 최근 비약적인 발전을 통해 이미지 분류 및 객체 인식 영역에서 크게 활용되고 있다.

컴퓨터 비전 기술의 대략적인 파이프라인은 (1)데이터 입력 (2)데이터 전처리 (3)데이터로부터 특징 추출 (4)인공지능 모델 학습/예측으로 정리할 수 있다.

(1)입력 데이터는 이미지 혹은 동영상 등이 될 수 있는데, 동영상도 각각의 Frame은 개별 이미지로 여겨질 수 있다. (2)데이터 전처리 과정에서는 이미지의 크기를 표준화 하거나, 색상을 변화시키고 노이즈를 제거하는 등의 작업이 이루어진다. (3)이미지로부터 특징(Feature)을 추출하는 과정인데, 이 특징은 해당 이미지가 무엇인지를 판단하는 근거가 된다. (4)추출된 특징을 인공지능 알고리즘에 입력하여 학습을 시키고, 학습된 알고리즘을 통해 새로운 이미지를 해석하는 단계이다.

■이미지 분류를 통한 검사 지능화

제조 현장에 인공지능 기술을 적용함에 있어 크게 5가지 분야로 제시된 영역 중에서 생산된 제품의 품질을 판단하는 검사 지능화 영역을 우선 생각해볼 수 있다. 이미지 분류는 미리 정의된 레이블을 새로운 이미지에 부여하는 작업이며, 입력 데이터와 정답 데이터를 짝을 이루어 학습하는 지도학습 방식을 따른다.(연재기고(5)) 제조현장에서의 이미지 분류 예시로서, 제품의 검수 단계에서 이미지 검사를 통해 양품과 불량품을 판정하는 경우를 생각해볼 수 있다.

입력 이미지로부터 양품의 제품이 갖는 특징과 불량품이 갖는 특징을 합성곱 신경망(Convolutional Neural Network, CNN)을 통해서 추출하게 되는데, CNN은 이렇게 이미지에서 특징을 추출하는데 특화되어 개발된 다층 퍼셉트론 (MultiLayer Perceptron, MLP) 구조이다. 양품과 불량품으로 구별된 빅데이터 이미지를 통해 학습된 인공지능 모델은, 새로운 이미지에 대해서 양품 혹은 불량품으로 예측할 수 있는 능력을 갖게 된다.

이 때 학습된 알고리즘 모델의 성능을 평가함에 있어서 주로 정확도가 활용되는데 때때로 정확도만으로는 인공지능 모델의 성능을 평가할 수 없는 경우가 있다.

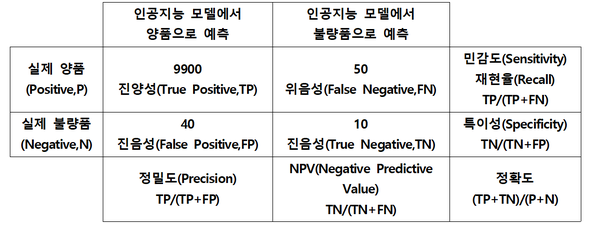

예를 들어, 특정 제품의 경우에 불량품이 총 생산제품 1만개 중 50개꼴로 발생하는 경우를 생각해보자. 이 경우에는 인공지능 모델에서 아무 학습도 하지 않고 무조건 양품이라고 예측하는 경우에도 99.5%의 정확도를 갖게 된다. 매우 높은 정확도이지만, 이 모델로는 실제 불량품을 찾아낼 수 없을 것이다. 이러한 경우에 활용하는 것이 혼동 행렬표(Confusion Matrix)이다. 혼동 행렬표는 인공지능 모델이 분류해 놓은 결과를 정리해놓은 표이다. 예를 들어, 1만개의 제품을 대상으로 양품과 불량품을 예측한 결과표가 <표1>과 같다고 생각해보자.

▲ <표1>혼동 행렬표

▲ <표1>혼동 행렬표인공지능 모델로부터 불량품으로 판정을 받은 제품은 고객사로 출고되지 않을 것이고, 양품으로 판정 받은 제품만 납품이 될 것이다. 모델이 정확하지 못하여, 실제 양품을 불량품으로 판정한 오류가 치명적일 것인가, 아니면 실제 불량품을 양품으로 판정한 오류가 치명적일 것인가. 이 경우에는 후자가 훨씬 치명적인 결과를 가져올 것이므로 진음성 항목을 더 중요하게 다루어야 할 것이다.

이 경우에 모델의 정확도는 99.1%로 높으나, 특이성의 경우에는 20%로 실제 불량품 중에 20%만 인공지능 모델에서 불량품으로 판단할 수 있다는 의미가 된다. 이와 같이 제조 현장의 상황에 따라 적합한 지표를 선택하여 인공지능 모델을 학습하는 것이 필요하다. 그리고 불량의 원인이 다양한 경우에도 다중 분류 문제로 레이블링을 진행하여 동일한 과정을 거쳐서 이미지 분류를 진행할 수 있을 것이다.(연재기고(5))

■객체 탐지를 통한 검사 지능화

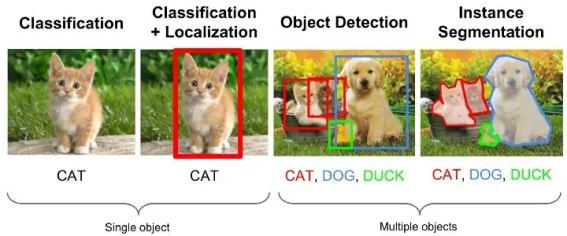

이미지 데이터를 통해 정보를 판단할 때에 이미지 자체로 분류가 되고 해당 이미지의 카테고리가 무엇인지 분별하는 것에 더하여, 이미지 안의 특정 영역이 중요해지는 경우가 있다. 하나의 이미지 안에서 여러 가지 관심 대상이 있을 수도 있고, 해당 영역을 특정해서 표시해야하는 경우도 생기는데, 이러한 작업은 객체 탐지(Object Detection) 영역에 속한다.

▲ <그림1>이미지 분류와 객체 탐지의 개념 비교 (출처:https://medium.com/zylapp/review-of-deep-learning-algorithms-for-object-detection-c1f3d437b852)

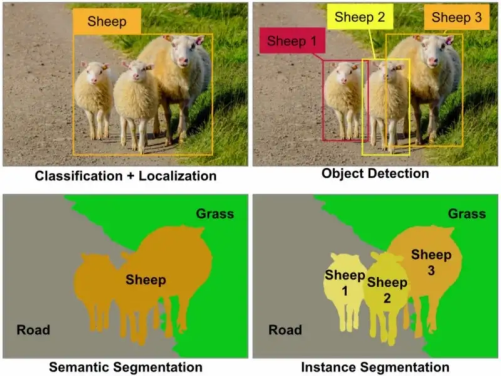

▲ <그림1>이미지 분류와 객체 탐지의 개념 비교 (출처:https://medium.com/zylapp/review-of-deep-learning-algorithms-for-object-detection-c1f3d437b852) <그림 1>에서 첫 번째 고양이 사진이 이미지 분류를 설명하는 것이라면, 두 번째 사진에서처럼 고양이가 있는 위치 정보를 추가로 표시하는 것이 객체 탐지 시스템으로 볼 수 있다. 객체 탐지에는 세 번째 그림처럼 복수의 카테고리를 표시하는 기능이 포함되어 있으며, 네 번째 사진에서처럼 탐지된 객체의 형상을 따라서 픽셀단위로 객체의 영역을 표시하는 기법도 포함한다. 특히 마지막 네 번째 사진과 같이 픽셀 단위로 영역을 표시하는 기법을 객체 분할(Object Segmentation)로 부르는데 이것은 다시 의미론적 분할(Semantic Segmentation), 의미있는 객체의 분할(Instance Segmentation)로 나눌 수 있다. 의미론적 분할은 같은 클래스에 속하는 객체들을 같은 영역으로 분할하는 기법이다. <그림 2> 의 왼쪽 그림에서 모든 양을 동일한 색으로 분할하였다. 이에 반해 의미있는 객체의 분할의 경우(<그림 2>의 오른쪽)에는 각각의 양을 따로따로 분할하였다.

▲ <그림2>객체 분할 기법 개념 비교 (출처:https://towardsdatascience.com/detection-and-segmentation-through-convnets-47aa42de27ea)

▲ <그림2>객체 분할 기법 개념 비교 (출처:https://towardsdatascience.com/detection-and-segmentation-through-convnets-47aa42de27ea)이러한 영역 분할 기법은 검사 지능화 영역에서 결함 부위를 특정하는데 활용될 수 있다. 제조 현장에서 생산되는 제품의 표면 결함 뿐만 아니라, X-ray나 CT 검사를 통해 얻어진 제품 내부의 결함 위치도 파악하는데 활용될 수 있다. <그림 3>은 알루미늄 주조품의 CT 검사 이미지 분석 예시이다. 원본 이미지에서 내부 결함에 해당되는 부분을 픽셀단위로 레이블링을 하고 Bounding Box로 표시를 하여 Ground Truth(정답 이미지)로 활용하였다. 원본 입력 이미지와 정답 이미지를 짝으로 지도학습하여 인공지능 모델을 만든 후 새로운 입력에 대해서 내부 결함 위치를 예측하는데 활용할 수 있다. 연재기고(6) <유형 3>에서도 영역 분할 기법을 적용하여 주조 제품의 표면 불량 발생 문제점을 해결하는 예시가 소개 되었다.

▲ <그림3>CT 검사 이미지를 통한 제품 내부 결함 예측

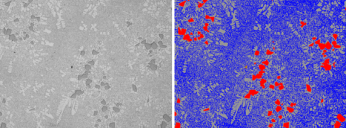

▲ <그림3>CT 검사 이미지를 통한 제품 내부 결함 예측 또한 영역 분할 기법은 연재기고(5)의 <그림 2>에서처럼 설계 지능화 분야의 합금소재 미세조직을 분석하는데에도 유용하게 활용될 수 있다. 합금 소재를 개발할 때에는 미세조직을 관찰하는 것이 필수적인데, 합금의 물성이 합금을 구성하는 상(Phase)의 분포와 밀접한 관련이 있기 때문이다. 합금을 구성하는 각 상(Phase)은 고유의 물성이 서로 다르고, 표면의 거칠기(Roughness)가 서로 다르기 때문에 현미경으로 관찰할 때에 시각적으로 구분되어 보이게 된다. 미세조직 이미지에서는 상(Phase)별로 분할을 해주어야하기 때문에 의미론적 분할 기법을 적용하여 인공지능 모델을 학습할 수 있으며, <그림 4>는 광학 현미경을 통해 관찰된 합금의 미세조직 이미지와 예측 이미지 예시를 보여준다.

▲ <그림4>광학 현미경을 통해 관찰된 합금 미세조직 이미지 (좌)입력이미지, (우)예측이미지

▲ <그림4>광학 현미경을 통해 관찰된 합금 미세조직 이미지 (좌)입력이미지, (우)예측이미지■전이 학습을 통한 이미지 데이터 학습

제조 현장 상황에 맞는 이미지 데이터 학습을 통해 인공지능 모델을 새로 구축하기 위해서는 방대한 양의 데이터를 수집하고 레이블링 해야 하며, 학습 과정 자체에도 긴 시간이 필요할 것이다. 그러나 이미 사전 학습되어 공개되어 있는 인공지능 모델을 활용하여 현재 상황에 맞는 새로운 인공지능 모델을 만들 수 있다면 훨씬 효율적일 것인데, 전이 학습을 통해 이것이 가능하다.(연재기고(5)) 합성곱 신경망(CNN) 기술이 발전함에 따라 LeNet, AlexNet, VGGNet, GoogLeNet, ResNet, SENet 등과 같은 다양한 모델들이 개발되어 공개되어 있다.

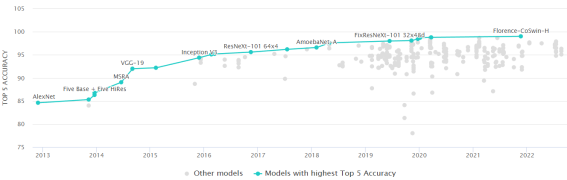

<그림5>는 지난 2013-2022년까지 ImageNet 데이터를 활용하여 이미지 분류 정확도를 높이기 위해 개발된 많은 모델들과 해당 모델의 Top-5 정확도를 보여준다. 2016년 이후로는 흔히 Human Accuracy 라고 여겨지는 95% 보다 더 높은 정확도를 보이는 모델들도 많이 개발 되었다. 다만, Top-5 정확도라는 것은 이미지를 분류함에 있어 가장 높은 확률로 정답을 맞히지는 못해도 예측 확률 상위 5가지 안에만 포함되면 잘 분류한 것으로 판단하여 수치를 계산하는 방식이기 때문에 제조 현장에 적용할 때에는 현장 상황과 풀고자 하는 문제에 맞게 새로운 모델의 가중치를 미세 조정하여 사용하는 것이 필요할 것이다.

▲ ImageNet의 이미지 분류 모델 및 Top-5 정확도 결과 (2013-2022) (출처:https://paperswithcode.com/sota/image-classification-on-imagenet?metric=Top%205%20Accuracy)

▲ ImageNet의 이미지 분류 모델 및 Top-5 정확도 결과 (2013-2022) (출처:https://paperswithcode.com/sota/image-classification-on-imagenet?metric=Top%205%20Accuracy)■이미지 데이터 인공지능 학습

어떤 문제를 인공지능 기술로 풀 수 있느냐/없느냐를 논의할 때 종종 ‘인간이 할 수 있는 일은 인공지능으로도 할 수 있다’라는 말이 사용된다. 비슷하게 컴퓨터 비전 기술을 통해서 어떤 문제를 풀 수 있을까를 논의할 때에도 마찬가지로 ‘If the eye can do it, so can the machine’(출처:Computer Vision 5th ed. E.R.Davies) 이라는 말이 원칙이 된다고 생각한다.

제조 현장에서 눈으로 판단하는 많은 문제들을 인공지능 기술을 활용하여 접근하려는 시도가 점차 늘어나고 있다. 인공지능 모델을 학습시키기 위한 양질의 이미지를 얻기 위한 하드웨어 및 통신 기술도 매우 중요한 요소이며, 이후 이미지 전처리 및 모델 학습, 현장 설치 및 활용까지 통합적인 기술을 통해 제조현장에 인공지능 기술을 적용하려는 노력이 시도되고 있는 추세이다. 지속적인 노력을 통해 인공지능 기술을 활용하여 제조업이 가진 난제들을 조금씩 해결해 나갈 수 있길 기대한다.